Comment gérer la qualité des données d’un Entrepôt de Donnée de Santé ?

Introduction :

Lorsque vous vous rendez à l’hôpital, vous ne le savez peut-être pas mais vous laissez des traces numériques. Qu’advient-il de ces données ? comment sont-elles utilisées ?

Presque 100% des données collectées dans les hôpitaux à travers la pratique clinique quotidienne sont inexploitables directement pour la recherche, elles doivent systématiquement être étudiées et qualifiées avant de pouvoir être utilisées.

Ce sujet, c'est le sujet "qualité des données", trop souvent sous-estimé, que nous allons voir ici ensemble,

En France depuis 2021, les établissements de santé bénéficient d'un cadre légal proposée par la CNIL, aussi appelé EDS pour Entrepôt de Données de Santé permettant la réutilisation secondaire des données produites lors de la pratique clinique quotidienne et ceci pour le soin ou la recherche.

Pour un EDS, la qualité des données est aussi importante que la sécurité, bien qu'elle ne soit pas mentionnée dans le rapport de la CNIL, cette dernière joue un rôle primordial dans l'éventail des usages possibles qui en seront faits lors de l'exploitation de celui-ci.

Dans cet article, nous allons tenter de répondre à la question de la gestion de la qualité des données nous servant à exprimer une proposition méthodologique.

Il existe plusieurs façons d'aborder la gestion de la qualité des données :

Dans cet article nous choisirons 3 angles différents :

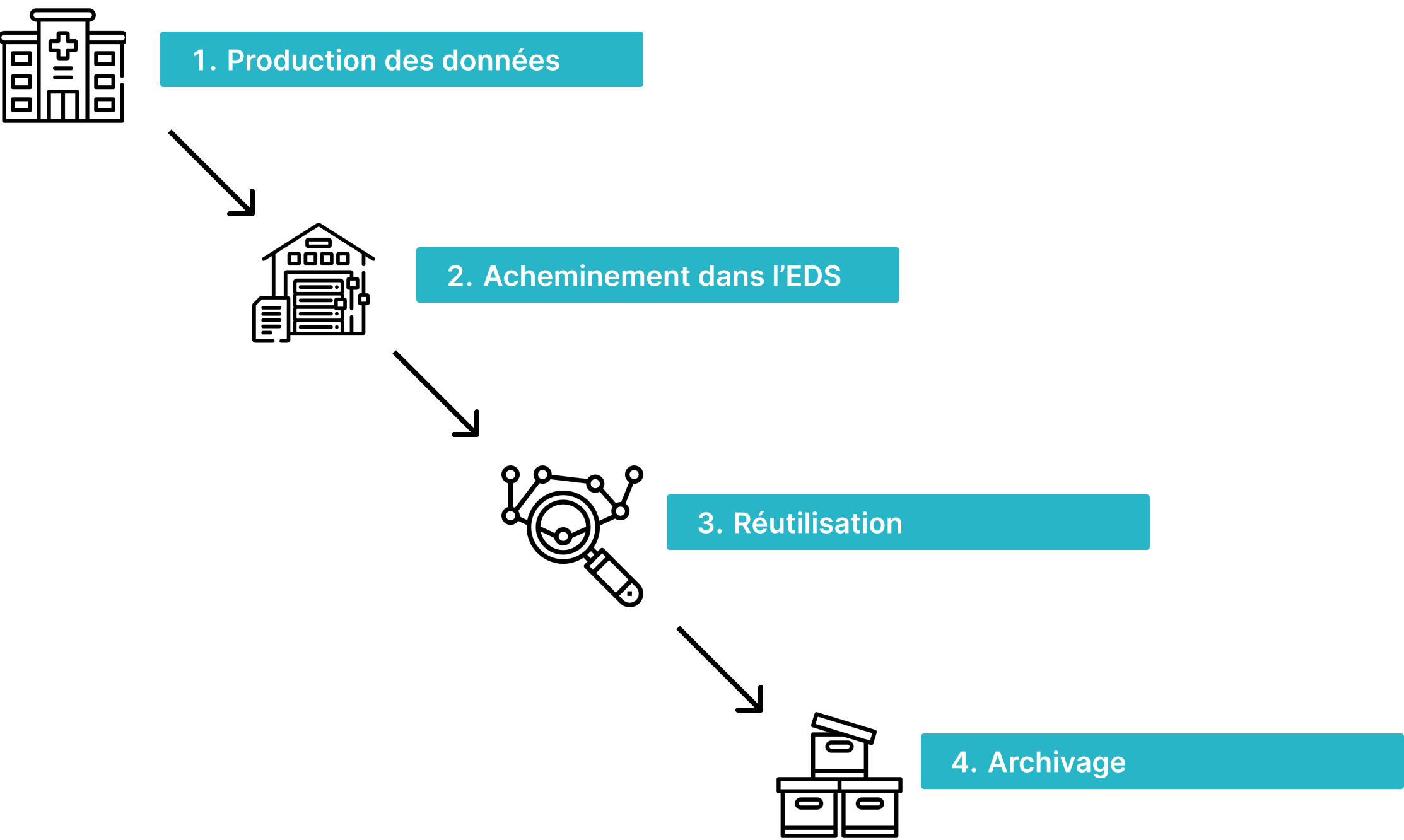

- Le premier se base sur l'approche par le cycle de vie de la donnée. Nous irons de la production de la donnée à partir du système hospitalier, jusqu'à son archivage en passant par les traitements informatiques intermédiaires pour l'acheminer dans l'entrepôt, et la réutilisation dans le cadre de projets.

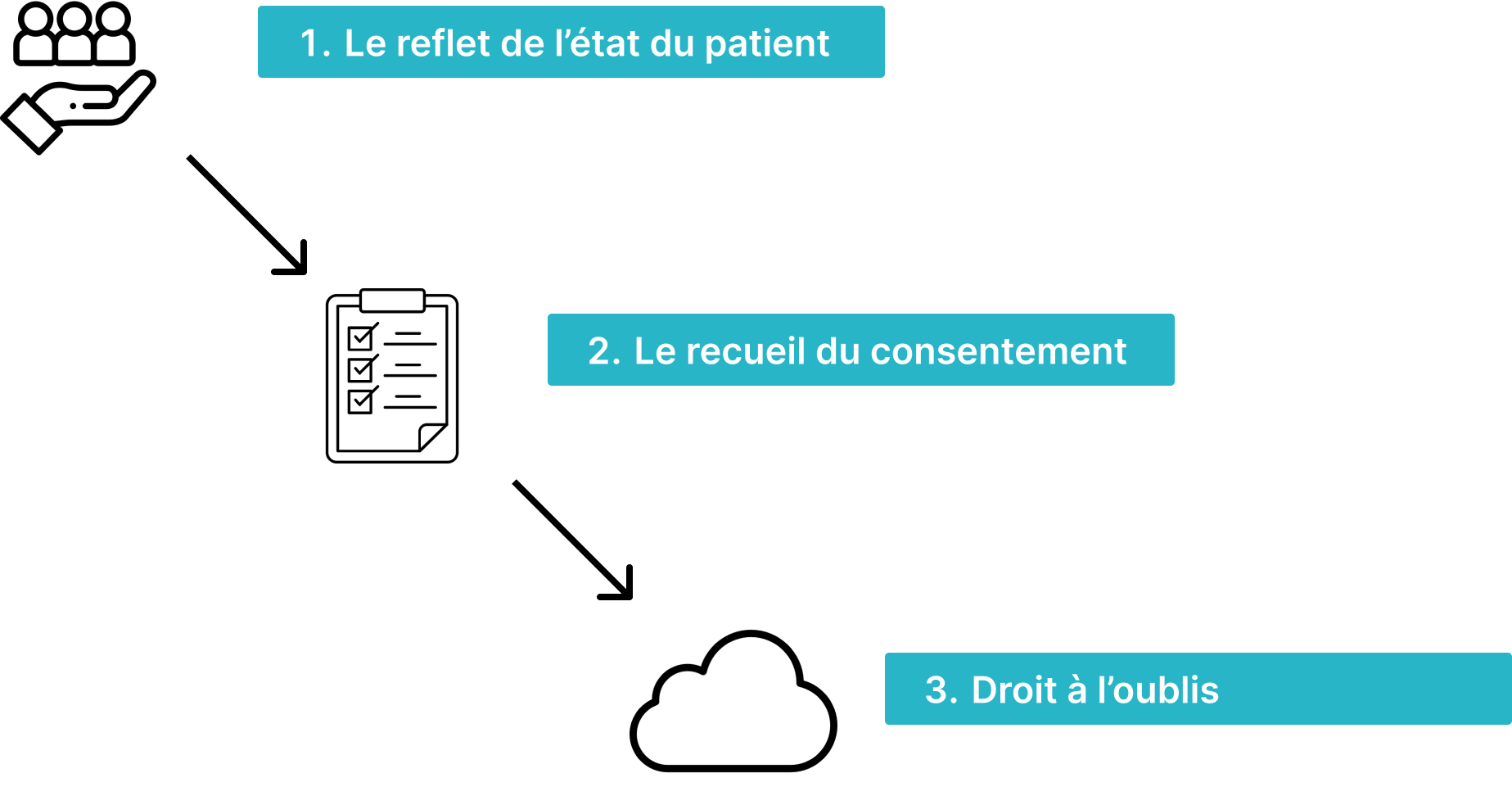

- La deuxième approche sera une approche centrée sur l'humain. Nous aborderons la donnée en tant que reflet du patient. Nous irons du recueil du consentement jusqu'à jusqu'au droit à l'oubli, la prescription, en passant par la réutilisation de la donnée dans le respect du RGPD.

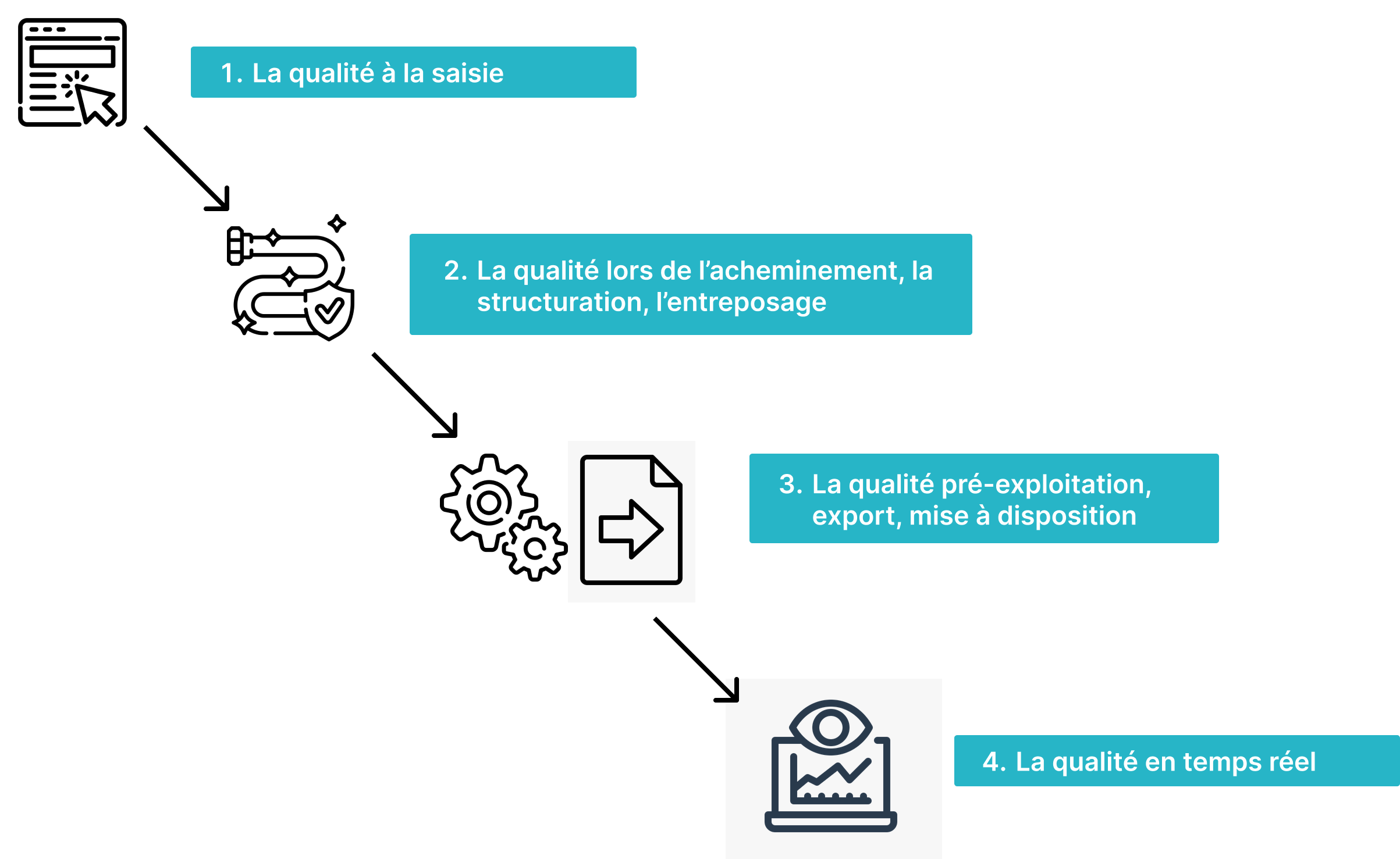

- Enfin, le troisième angle se base sur l'approche technique ; nous irons des modalités de saisie de la donnée jusqu'à sa validation en temps réel, en passant par la structuration, l'entreposage, l'acheminement et la mise à disposition dans les espaces projets.

Plan :

Angle 1 : Approche cycle de vie de la donnée

- La production des données

- L’acheminement dans l’EDS

- La réutilisation

- Le décommissionnement / archivage

Angle 2 : Approche humain centrée

- La donnée de santé, le reflet de l’état du patient

- Le recueil du consentement

- Ouverture : Et après ? Droit à l’oubli, prescription, durée d’un consentement ?

Angle 3 : Approche Qualité centrée

- La qualité à la saisie

- La qualité lors de l’acheminement, la structuration, l’entreposage

- La qualité pré-exploitation, export, mise à disposition

- Ouverture : La qualité en temps réel

1 : Approche cycle de vie de la donnée

- La production des données

Une des particularités du secteur de la santé réside dans la pluralité des types de données produites. En effet, un hôpital peut générer des données d'imagerie à travers les Radiographies, TEP-SCAN, IRM; et autres appareils d'imagerie, mais il peut aussi produire des données cliniques, en lien avec l'état civil du patient, des données sociodémographiques, ou encore des données administratives, mêlées à des données pharmacologiques en lien avec ses traitements et protocoles de soins.

Dans les hôpitaux, cette variété de données est produite par une pléthore de logiciels, constituant ensemble le système d'information hospitalier, unique à chaque établissement. Chaque hôpital ayant une diversité de pratiques de soins distinctes et des spécialisations dans les types de maladies traitées.

Cette diversité engendre une très grande complexité pour définir un cadre clair et simple de gestion des données. La multitude et la diversité de productions de données rendent difficile l'établissement d'une méthodologie uniforme et efficace pour gérer sa qualité. En somme, chaque hôpital, avec son système d'information unique, doit naviguer dans un environnement complexe où la gestion de la qualité des données représente un défi majeur.

Solution :

Dans ce cadre, il devient, de fait impossible de définir un cadre standardisé. La solution consiste alors à subdiviser le système d'information et à ne retenir que les parties dont on souhaite exploiter les données à des fins de réutilisation. Dans notre approche, les données sont référencées comme des sources de données avec leurs caractéristiques propres. Ainsi, cette méthodologie permet une adaptation et une montée en puissance graduelle de l'approche d'assurance qualité sur le patrimoine de données de l'hôpital.

- L’acheminement dans l’EDS

L'acheminement des données dans l'EDS est une partie technique complexe et à chaque fois unique. En effet, il faut prendre en compte les montées de version des logiciels des fabricants ainsi que l'historique du système d'information source et son évolution au travers des années. Une tâche ardue qui nécessite généralement plusieurs mois voire plusieurs années afin d'être menée à bien, avec un travail en amont sur la définition des données sources que l'on souhaite importer dans l'entrepôt mais aussi dans leur forme finale, une fois stockées et entreposées.

Solution :

Il n'existe pas de façon unique et optimale de mener à bien cette tâche, néanmoins, on peut considérer que, par la complexité de la mise en œuvre et les délais de réalisation, il est très fortement probable que des erreurs humaines ou techniques interviennent lors de ce processus.

C'est pourquoi, imaginer l'étude de la qualité de la donnée, intégrée au processus d'acheminement, est illusoire. Cela amènerait une couche de complexité supplémentaire dans une démarche déjà suffisamment complexe. Il existe néanmoins des outils logiciels permettant de mener à bien ce type de tâches.

Notre proposition est de ne pas intervenir lors du processus d'acheminement mais plutôt d'étudier la qualité à l'arrivée basé sur le cahier des charges définis en amont quant à la structure et aux caractéristiques attendues une fois dans l'entrepôt.

Ainsi, Le travail de mise en qualité peut être mené en parallèle du travail d'acheminement de la donnée dans l'entrepôt car ne se superposant pas avec ce dernier en termes de dépendances fonctionnelles. De plus, les outils logiciels pour l'acheminement peuvent être totalement différents des outils servant à assurer la qualité des données, Réduisant la courbe d'apprentissage des équipes menant ces chantiers.

- La réutilisation

La réutilisation des données est déclenchée par la mise à disposition d'un sous ensemble de données entreposées répondant à un sujet de recherche ou de soins dans ce que l'on appelle un espace projet.

Même si la donnée a bien été stockée, le processus d'export ainsi que l'acheminement dans l'espace projet peuvent faire intervenir des erreurs de manipulation dégradant la qualité de la donnée, ainsi l'utilisateur final, devra une fois encore revérifier que celle-ci correspond bien aux critères émis pour le projet, notamment pour les sujets de data science poussée comme l'entraînement de modèles de machine learning ou leur utilisation pour l'inférence.

Là encore, notre méthodologie se propose d'intervenir pour produire une ultime analyse en capitalisant sur les travaux précédents lors de l'assurance qualité à l'entreposage.

- Le décommissionnement / L'archivage

Afin de respecter les critères du RGPD la CNIL mentionne un délai d'archivage de maximum 10 à 15 ans ans après la fin du sujet de recherche, La question de la réintégration des données produites lors du sujet de recherche se pose ainsi et l'assurance de leur qualité résultant également. Là encore dans une approche classique, une étude ad hoc serait nécessaire là où notre méthodologie se propose de réutiliser les mêmes travaux d'assurance qualité à l'entreposage.

Conclusion :

Là où naturellement le plan d'assurance qualité serait mené au sein de la démarche d'entreposage ou de réutilisation, Il apparaît évident après réflexion, qu'une méthodologie d'assurance qualité par "sondage" à des étapes clés du cycle de vie permet une plus grande souplesse, ainsi qu'une meilleure optimisation des travaux d'assurance qualité, car les programmes ainsi produits sont plus modulaires et utilisables de façon plus "couteaux suisses" que dans une méthodologie totalement intégrée.

2 : Approche humain centrée

- La donnée de santé, le reflet de l’état du patient

Dans le secteur de la santé, la donnée revêt un aspect beaucoup plus personnel et sensible, En effet, elle est souvent la traduction d'un état biologique du patient. De ce fait, une assurance de l'exactitude des informations enregistrées apparaît d'une importance capitale, pour ne pas dire vitale.

En plus de l'importance de l exactitude des informations enregistrées, n'oublions pas également que contrairement aux autres secteurs, de par sa nature particulière, la donnée de santé doit être considérée comme un bien personnel appartenant au patient, dont il faut recueillir le consentement avant de pouvoir l'exploiter dans le cadre d'autres finalités que le soin direct.

- Le recueil du consentement

Il existe plusieurs façons de recueillir le consentement du patient, La première étant de lui demander via un formulaire dès la première saisie dans le système d'information hospitalier des informations cliniques.

La seconde à travers une communication directe lors de la mise en place d'un projet de recherche dont il apparaît que le patient fasse partie des critères d'inclusion.

Finalement, parfois, selon le sujet de recherche et le format de donnée exploité, le consentement n'est pas nécessaire car la donnée est agrégée et devient de fait anonyme.

Une fois le recueil du consentement établi, intervient la phase de discrimination des données patients selon son consentement positif ou négatif, cette phase peut être très complexe et demande de mettre en place à la fois une organisation et des outils techniques de gestion du consentement et de traçabilité des opérations de traitement de la donnée. Ce sujet est explicité dans le chapitre 9 du référentiel de la CNIL sur les entrepôts de données de santé intitulé "droit des personnes".

Dans ce cadre, un outil de data Quality intégrant la dimension de cohérence (vérification de correspondance entre deux sources) permettrait de vérifier la bonne application du consentement patient dans les exports de données dans les espaces projets, servant ainsi en partie de solution technique.

- Et après ? Droit à l’oublis, prescription, durée d’un consentement ?

Un des cas particuliers énoncés par le RGPD est le décès du patient, invalidant de fait le recueil du consentement, rendant les données par défaut utilisables dans le cadre de la recherche.

Mais qu'en est il des vivants ?, alors que la CNIL nous rappelle que le droit d'opposition est applicable à n'importe quel instant, qu'elle est la solution la plus pragmatique à mettre en place pour assurer ses droits fondamentaux et une utilisation fluide des données ?

Cette question ne trouve pas encore de réponse car la problématique est trop récente et il faudra sans doute plusieurs années pour faire ressortir une solution convenable d'un point de vu technique et légal.

3 : Approche Qualité centrée

- La qualité à la saisie

La qualité des données peut être étudiée de différentes manières, la première étant l'application des contraintes de cohérence et de validité lors de la saisie. Dans ce domaine, la plupart des outils de saisie de formulaires intègrent déjà des règles métier qui aident à prévenir l'entrée d'informations erronées. Cependant, cela n'est pas systématiquement garanti et dépend fortement de la qualité des logiciels métiers installés et du sérieux de l'éditeur de ces logiciels.

Dès lors, il apparaît indispensable de mettre en place des contrôles de cohérence sur les données saisies pour pallier aux éventuelles manquements de règles métier lors de l'ajout d'informations. D'une façon générale, parce que les pratiques sont différentes entre les établissements de santé, et malgré une configuration parfois poussée des logiciels, il est impossible d'y intégrer toutes les règles métier, introduisant de fait des failles pour la saisie.

Solution :

Notre méthodologie, se propose de créer des programmes consignant de façon exhaustive les règles métier pour garantir la cohérence et la validité attendues des données saisies. Ce travail pourrait bénéficier non seulement à la réutilisation secondaire mais aussi à son utilisation primaire lors de la pratique clinique.

- La qualité lors de l’acheminement, la structuration, l’entreposage

Selon sa modalité, la donnée devra subir des transformations à partir de sa source dans le système d'information hospitalier jusqu'à son entreposage dans l'EDS.

En effet, elle devra être correctement structuré si par exemple la donnée est une donnée non structurée comme un rapport d'analyse ou un compte rendu médical, ou encore parce qu'elle devra être croisée avec plusieurs sources afin d'être entreposé dans une vue métier spécifique.

À chaque étape, de la structuration à l'entreposage en passant par l'acheminement, les contrôles qualité permettent de garantir l'intégrité et un haut niveau de confiance dans l'information traitée. La granularité ainsi que la quantité des contrôles qualité dépendent énormément des typologiques de données et du seuil de confiance désiré. Dans un souci de pragmatisme le recours systématique au contrôle qualité n'est pas nécessairement souhaitable, en effet plus on augmente le nombre de contrôles, plus on augmente la charge de travail qui incombe aux équipes de data ingénieurs et de data manager pour maintenir ces contrôles.

Il apparaît alors qu'un juste équilibre entre la quantité et la fréquence des contrôles soutenu par un haut niveau d'automatisation permet d'atteindre un seuil acceptable de confiance dans la qualité des informations finalement entreposées dans l'EDS. Dans ce cadre, la solution se retrouve plus dans un aspect de gouvernance de la donnée que technique.

- La qualité pré-exploitation, export, mise à disposition

Après avoir correctement qualifié la donnée à sa saisie dans le système hospitalier puis d'avoir fait des contrôles systématiques et automatiques à différents endroits de la chaîne de traitement pour son acheminement dans l'EDS, vient la qualification lors de la création du sous ensemble de données requis pour un projet de recherche. En effet La plupart des projets de recherche nécessitent un croisement des informations provenant de l'entrepôt de données et donc de fait un travail de data ingénierie et de data management pour leur constitution. il faut alors une dernière fois vérifier la conformité du dataset mis à disposition dans l'espace projet avec les critères attendu par celui ci.

Ce travail peut être réalisé ponctuellement, mais peut s'avérer complexe lors de projets multicentriques, dans ce cadre une solution technologique peut amener à des gains substantiels de temps lors de la mise en commun des sous-ensembles de données.

- Ouverture : La qualité en temps réel

Dans le cadre de la réutilisation des données pour soutenir la pratique clinique à l'aide de technologies innovantes, telles que des modèles d'intelligence artificielle intégrés dans des dispositifs médicaux, il est crucial de considérer l'étude de la qualité des données en temps réel. En effet, les étapes de structuration, d'acheminement et d'entreposage peuvent prendre plusieurs heures, voire plusieurs jours. Il n'est pas raisonnable d'attendre si longtemps pour obtenir des informations qualifiées dans un contexte clinique. Il devient donc indispensable de réaliser ces contrôles en temps réel afin de rester réactifs et de réduire le temps de prise en charge des patients. À ce jour, il n'existe pas d'outils technologiques capables de répondre à cette nouvelle exigence.

Conclusion :

Nous venons de le voir, le cycle de vie des données, lorsqu'elles sont réutilisées à des fins de soins ou de recherche, soulève plusieurs problématiques fondamentales. Un travail technique et organisationnel approfondi est nécessaire pour garantir la sécurité des données, promouvoir la recherche et respecter les droits des patients. Dans ce contexte, une approche d'assurance qualité cohérente et pragmatique offre un véritable gain de temps et facilite la mise en place d'une stratégie de gestion des données performante. Cette approche proposant un cadre méthodologique à la fois flexible et contraignant.

Références :

- Jugulum, Rajesh. "Competing with High Quality Data". Wiley, 2014. Print.

- Olson, Jack E. "Data Quality : The Accuracy Dimension". Morgan Kaufmann, 2003 Print.

- Batini, Carlo, and Minca Scannapieco. "Data Quality : Concepts, Methodologies and Techniques". Springer, 2006. Print.

- English, Larry. "Information Quality Applied : Best Practices for Improving Business Information, Processes, and Systems". Wiley Publishing, 2009. Print.

- Maydanchik, Arkady. "Data Quality Assessment". Technics Publicactions, LLC, 2007 Print.

Pour en savoir plus et nous contacter -> https://qalita.io/