Décryptage des premiers travaux du consortium européen QUANTUM

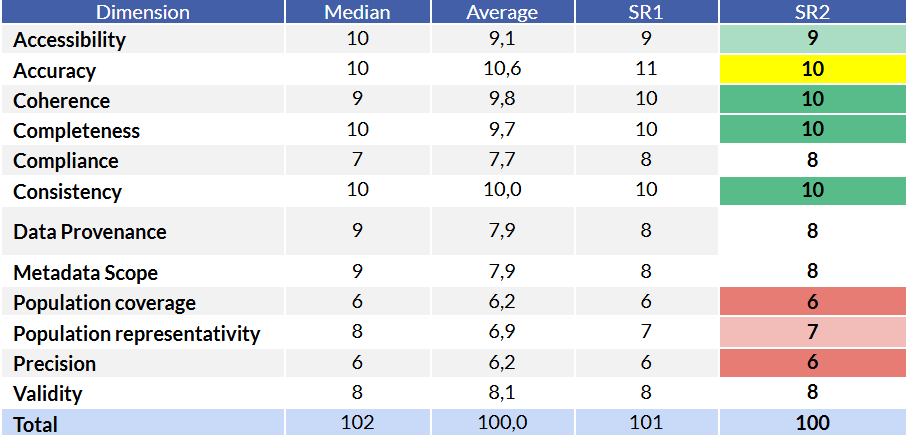

Le monde de la donnée est en quête de standardisation. Le consortium européen quantum, fort de 35 partenaires dans 15 pays européen, a franchi en février 2025 une étape cruciale en publiant les premières conclusions de ses travaux, comprenant une liste réduite des dimensions essentielles de la Data Quality (DQ).

Pour tout professionnel, comprendre ces dimensions n'est pas qu'une question de conformité, c'est la base d'une prise de décision fiable et d'une analyse pertinente.

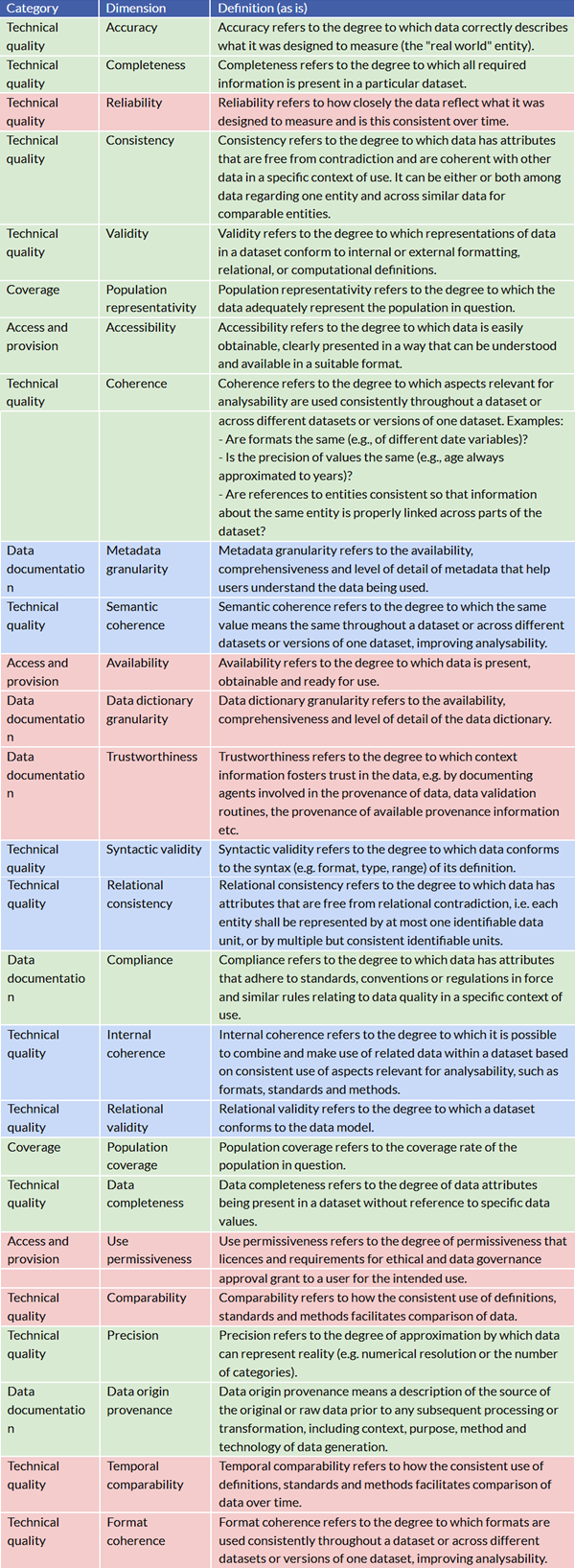

Cet article a pour but de décrypter ce cadre, en expliquant concrètement ce que chaque dimension de la DQ signifie et pourquoi elle est fondamentale. Les travaux du consortium structurent la DQ autour de quatre catégories principales :

- Qualité Technique

- Couverture

- Accès et Mise à disposition

- Documentation des Données.

1. La Qualité : Le "Moteur" de la Donnée

Cette catégorie est le cœur de la DQ, car elle garantit que la donnée est correcte, complète et cohérente. Si ces critères ne sont pas respectés, toute analyse ou algorithme sera biaisé.

Les dimensions techniques essentielles à maîtriser sont :

- Exactitude : C'est le critère de vérité. La donnée décrit elle correctement la réalité qu'elle est censée représenter ? Maîtriser l'exactitude évite les erreurs de ciblage ou de calcul.

- Complétude : S'assurer de la complétude permet une analyse exhaustive. Toutes les informations requises sont-elles présentes dans le jeu de données ? Une donnée manquante peut fausser les moyennes ou masquer des tendances.

- Cohérence : Ce critère assure que les données sont libres de contradiction entre elles, rendant les croisements de données logiques. Les travaux insistent sur la Cohérence interne et la Cohérence des formats, afin que tous les champs d'un même jeu de données parlent le même langage.

- Fiabilité : La donnée mesurée doit être consistante dans le temps. Ce critère est essentiel pour faire des comparaisons historiques fiables et assurer la stabilité du processus de collecte.

- Validité : La donnée doit respecter le format, le type et les règles définis. Ce critère garantit que la donnée est utilisable par les systèmes informatiques. Par exemple, une adresse e-mail doit avoir le bon format.

- Précision : Elle détermine le niveau de détail de l'analyse, en indiquant le degré d'approximation de la donnée par rapport à la réalité.

2. Couverture : Représenter le Monde Réel

La DQ ne se limite pas à la technique ; elle doit aussi refléter correctement le phénomène étudié. La catégorie Couverture s'assure que les données sont pertinentes par rapport à la population ou au sujet visé, et les travaux du consortium mettent l'accent sur deux critères clés.

Le premier est la Représentativité de la population. Il est fondamental que le jeu de données représente bien l'ensemble de la population cible, afin d'éviter de tirer des conclusions généralistes à partir d'un échantillon biaisé ou incomplet.

Le second critère est la Couverture de la population, qui évalue la portée de l'analyse en indiquant quel pourcentage de la population cible est réellement atteint. Un faible taux limite inévitablement la pertinence des résultats tirés de l'ensemble de données.

3. Accès et Mise à disposition : Rendre la Donnée Exploitable

Même des données parfaites sont inutiles si personne ne peut les trouver ou les utiliser, c'est pourquoi cette catégorie touche à la praticité et à l'éthique de l'utilisation des données.

Les dimensions de la Disponibilité et de l'Accessibilité sont les plus simples à comprendre : la donnée doit être présente et facilement récupérable dans un format adapté pour l'utilisateur final.

De plus, les Conditions d'utilisation constituent le volet légal et éthique indispensable. Elles définissent les autorisations accordées à l'utilisateur via les licences et les règles de gouvernance, ce qui est vital pour éviter les litiges ou les non-conformités réglementaires.

4. Documentation des Données : Instaurer la Confiance

Une donnée sans contexte n'a pas de valeur. La Documentation des Données est le pilier de la Confiance (Trustworthiness).

- Granularité des Métadonnées et des Dictionnaires de Données : Ces outils expliquent comment la donnée a été collectée et ce que chaque champ signifie. Plus ils sont détaillés, plus l'utilisateur a confiance dans la donnée.

- Provenance de l'origine des données : Savoir d'où vient la donnée originale est essentiel. Cela permet de retracer sa source, sa méthode de génération et de valider sa légitimité, assurant la traçabilité.

- Conformité : Ce critère garantit que la donnée respecte les normes légales, les conventions de l'industrie ou les standards internes.

En privilégiant ce shortlisting, le consortium offre une boîte à outils pédagogique claire. Il permet à chaque organisation de se concentrer sur les leviers les plus critiques de la DQ pour atteindre un niveau de qualité reconnu et mesurable.

QALITA et le Futur Label QUANTUM

QALITA ambitionne de devenir un acteur incontournable de la gestion de la qualité des données à l'échelle européenne en devenant le premier éditeur à proposer un outil conforme au futur label européen QUANTUM.

En s'alignant sur les dimensions clés identifiées par le consortium, QALITA développe des solutions logicielles qui intègrent nativement les exigences de Cohérence, de Validité et de Fiabilité. Notre engagement est d'offrir aux entreprises un avantage concurrentiel décisif, en transformant leurs données brutes en un actif stratégique de confiance, prêt pour les défis réglementaires et analytiques de demain.

Retrouvez les ressources QALITA

- 🎬 Chaine Youtube : tutoriels pas à pas et démonstrations pour faciliter l’adoption

- 💾 Documentation en ligne : garantir l’autonomie et un usage durable.

- 🚧 Github : pour suivre les évolutions et mises à jour régulières des fonctionnalités.